O projeto é apoiado por algumas das maiores estrelas da tecnologia, mas quatro países estão a investigar as suas práticas de privacidade.

É possível que tenha ouvido o nome Worldcoin recentemente. Tem recebido muita atenção — algumas boas, outras… não tão boas.

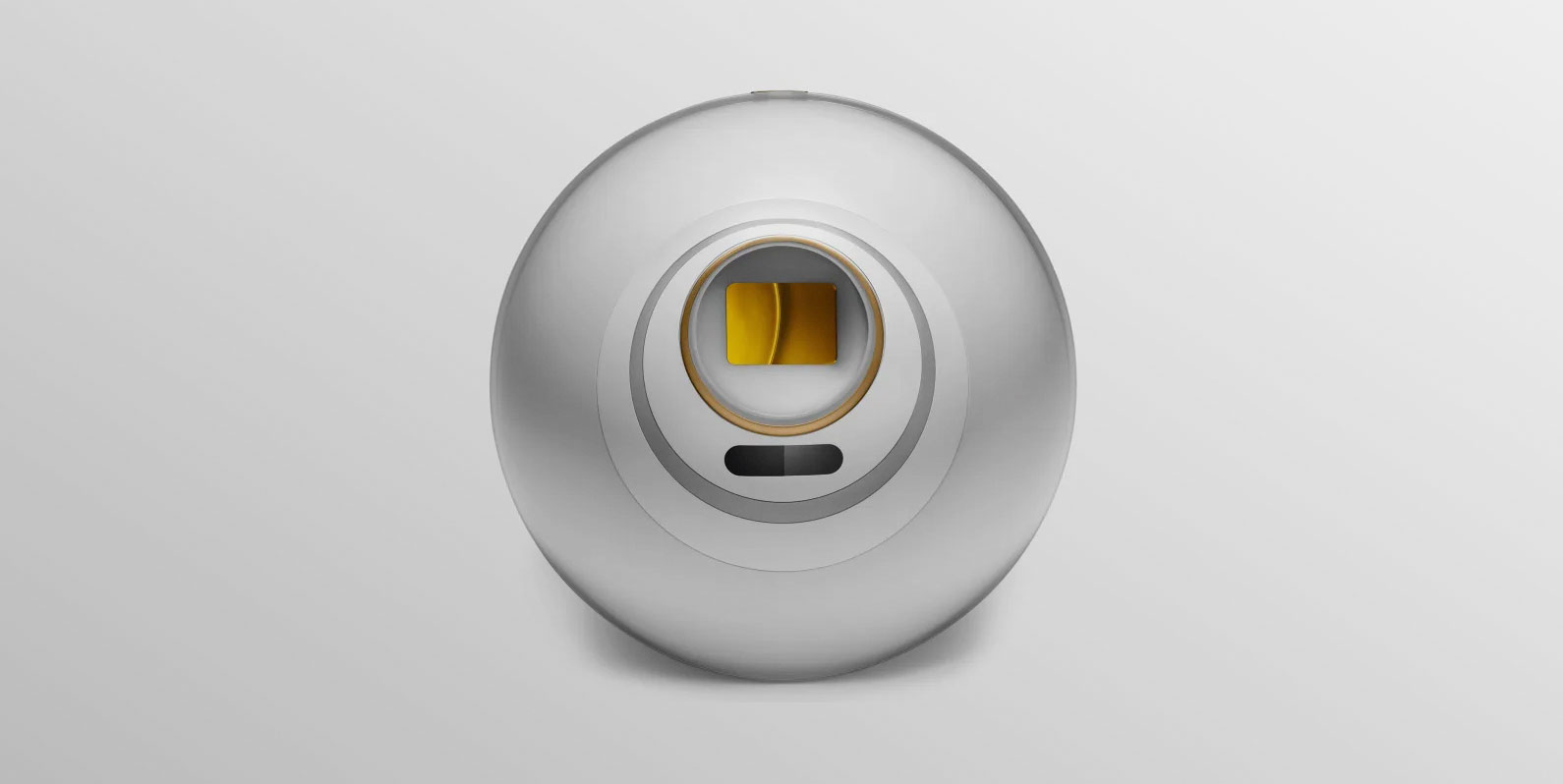

É um projeto que afirma usar criptomoeda para distribuir dinheiro em todo o mundo, embora sua maior ambição seja criar um sistema de identidade global chamado “World ID”, que se baseia nos dados biométricos exclusivos dos indivíduos para provar que eles são humanos. Ele foi lançado oficialmente em 24 de julho em mais de 20 países, e Sam Altman, CEO da OpenAI e uma das maiores celebridades da tecnologia no momento, é um dos cofundadores do projeto.

A empresa faz promessas grandes e idealistas: que pode oferecer uma forma de renda básica universal por meio da tecnologia para tornar o mundo um lugar melhor e mais equitativo, ao mesmo tempo em que oferece uma maneira de verificar sua humanidade em um futuro digital repleto de inteligência não humana, o que ela chama de “prova de pessoalidade”. Se você está pensando que isso soa como um possível pesadelo de privacidade, você não está sozinho.

Felizmente, temos alguém que eu consideraria o especialista em Worldcoin na equipe aqui da MIT Technology Review. No ano passado, a repórter investigativa Eileen Guo, juntamente com o freelancer Adi Renaldi, investigou a empresa e descobriu que as operações da Worldcoin estavam longe de atingir seus objetivos grandiosos e que ela estava coletando dados biométricos confidenciais de muitas pessoas vulneráveis em troca de dinheiro.

Como escreveram:

“Nossa investigação revelou grandes lacunas entre as mensagens públicas da Worldcoin, que se concentravam na proteção da privacidade, e o que os usuários experimentaram. Descobrimos que os representantes da empresa usavam práticas de marketing enganosas, coletavam mais dados pessoais do que reconheciam e não conseguiam obter um consentimento informado significativo.”

Além disso, a empresa estava usando os dados confidenciais, mas anônimos, dos usuários de teste para treinar modelos de Inteligência Artificial, contudo Eileen e Adi descobriram que as pessoas não sabiam que seus dados estavam sendo usados dessa forma.

Recomendo enfaticamente que você leia a investigação deles — que se baseia em mais de 35 entrevistas com executivos da Worldcoin, prestadores de serviços e usuários de teste recrutados principalmente em países em desenvolvimento — para entender melhor como a empresa estava lidando com dados pessoais confidenciais e como sua retórica idealista se comparava com a realidade local.

Considerando seus relatórios, não é de surpreender que os órgãos reguladores de pelo menos quatro países já tenham iniciado investigações sobre o projeto, citando preocupações com suas práticas de privacidade. A empresa alega que já escaneou cerca de 2,2 milhões de “seres humanos únicos” em seu banco de dados, que foi criado principalmente durante um longo período de testes nos últimos dois anos.

Então perguntei a Eileen: O que realmente mudou desde sua investigação? Como podemos entender as últimas notícias?

Desde sua história, o CEO da Worldcoin, Alex Blania, disse a outros meios de comunicação que a empresa mudou muitas de suas práticas de coleta de dados e privacidade, embora haja motivos para ceticismo. A empresa não especificou exatamente como fez isso, além de dizer que interrompeu algumas das táticas de recrutamento mais exploradoras e enganosas.

Em e-mails que Eileen trocou recentemente com a Worldcoin, um porta-voz foi vago sobre como a empresa estava lidando com dados pessoais, dizendo que “a Worldcoin Foundation cumpre todas as leis e regulamentos que regem o processamento de dados pessoais nos mercados em que a Worldcoin está disponível, incluindo o Regulamento Geral de Proteção de Dados (‘RGPD’) … O projeto continuará a cooperar com os órgãos governamentais em solicitações de mais informações sobre suas práticas de privacidade e proteção de dados”.

O porta-voz acrescentou: “É importante enfatizar que a Worldcoin Foundation e seu colaborador Tools for Humanity nunca venderam e nunca venderão os dados pessoais dos usuários”.

Mas, Eileen observa, não temos (novamente) nada além da palavra da empresa de que isso seja verdade. Esse é um dos motivos pelos quais devemos ficar atentos ao que os investigadores do governo começam a descobrir sobre a Worldcoin.

A legalidade da coleta de dados biométricos da Worldcoin está no centro de uma investigação do governo francês sobre e de uma investigação de uma agência alemã de proteção de dados que vem investigando a empresa desde novembro do ano passado, de acordo com a Reuters. Em 25 de julho, o Information Commissioner’s Officer do Reino Unido divulgou uma declaração de que estaria “fazendo investigações” sobre a empresa. Em seguida, em 2 de agosto, o Escritório de Proteção de Dados do Quênia suspendeu o projeto no país, dizendo que investigará se a Worldcoin está em conformidade com a Lei de Proteção de Dados do país.

É importante ressaltar que um dos principais objetivos do projeto Worldcoin é aperfeiçoar sua metodologia de “prova de pessoalidade”, que requer muitos dados para treinar modelos de IA. Se seu sistema de prova de personalidade for amplamente adotado, isso poderá ser bastante lucrativo para seus investidores, especialmente durante uma corrida do ouro da IA como a que estamos vendo agora.

A empresa anunciou esta semana que permitirá que outras empresas e governos implementem seu sistema de identidade.

“A solução de identidade proposta pela Worldcoin é problemática, independentemente de outras empresas e governos a utilizarem ou não. É claro que seria pior se ela fosse usada de forma mais ampla sem que tantas perguntas importantes fossem respondidas”, diz Eileen. “Mas acho que, nesta fase, é um marketing inteligente para tentar convencer todos a fazer o escaneamento e se inscrever para que eles possam alcançar a ‘mais rápida’ e ‘maior integração à criptografia e à Web3’ até hoje, como Blania me disse no ano passado.”

Eileen ressalta que a Worldcoin também ainda não esclareceu se ainda usa os dados biométricos coletados para treinar seus modelos de Inteligência Artificial ou se excluiu os dados biométricos já coletados de usuários de teste e que estavam sendo usados no treinamento, como disse à MIT Technology Review que faria antes do lançamento.

“Não vi nada que sugira que eles realmente pararam de treinar seus algoritmos — ou que algum dia o fariam”, diz Eileen. “Esse é o objetivo da IA, certo? Que ela deve ficar mais inteligente.”