A IA levou a avanços na descoberta de medicamentos e na área da robótica, e está no processo de revolucionar completamente a forma como interagimos com as ferramentas e com a Internet. A única complicação é o facto de não sabermos exatamente como funciona, ou por que razão funciona tão bem. Temos uma ideia geral, mas os detalhes são demasiado complexos para separar e examinar. Isto é um problema, pois pode levar-nos a utilizar um sistema de IA numa área extremamente sensível, como a da medicina, sem compreender que ele poderia ter falhas críticas incorporadas no seu funcionamento.

Uma equipa da Google DeepMind que estuda um ramo da IA explicável chamado mechanistic interpretability, o qual visa compreender as características de tomada de decisão de redes neuronais artificiais, tem trabalhado em novas formas de examinar os mecanismos internos da IA. No final de julho, a equipa disponibilizou a Gemma Scope, uma ferramenta para ajudar os investigadores a entender o que acontece quando a IA gera uma saída. A esperança é que, ao compreender melhor o que ocorre dentro de um modelo de IA, possamos controlar as suas saídas de forma mais eficaz, o que irá permitir melhores sistemas de IA no futuro.

“Quero poder olhar para o interior de um modelo e ver se me está a enganar”, diz Neel Nanda, chefe da equipa que investiga a mechanistic interpretability na Google DeepMind. “Parece que a possibilidade de ler a mente de um modelo pode ser uma ajuda”, afirma.

A mechanistic interpretability, ou “mech interp”, é um campo novo de pesquisa que tem como objetivo entender como as redes neuronais realmente funcionam. Atualmente, de forma muito básica, introduzimos dados num modelo e depois obtemos vários pesos no final do treino. Estes pesos são os parâmetros que determinam como o modelo toma decisões. Temos uma ideia daquilo que ocorre entre as saídas e os pesos: essencialmente, a IA identifica padrões nos dados e toma decisões a partir deles; no entanto, estes podem ser incrivelmente complexos e é, muitas vezes, extremamente difícil para os humanos interpretá-los.

A situação assemelha-se a um professor a avaliar as respostas de um problema de matemática complexo. O aluno (neste caso, a IA) escreveu a resposta certa, mas o trabalho parece uma série de rabiscos. Neste exemplo, assume-se que a IA indica sempre a resposta correta, mas isto nem sempre se verifica; ela pode ter identificado um padrão irrelevante que assume como válido. Por exemplo, alguns sistemas de IA atuais podem dizer que 9,11 é maior que 9,8. Diferentes métodos desenvolvidos na área da mechanistic interpretability estão a começar a esclarecer o que pode estar a acontecer, estando, essencialmente, a compreender os rabiscos.

“Um dos objetivos principais da mechanistic interpretability é tentar executar engenharia inversa dos algoritmos dentro desses sistemas”, diz Nanda. “Damos uma prompt ao modelo, como ‘Escreve um poema’, e ele escreve alguns versos rimados. Qual é o algoritmo utilizado para fazer isto? Adoraríamos entendê-lo.”

Para encontrar características, ou categorias de dados que representem um conceito maior, no seu modelo de IA, Gemma, a DeepMind usou uma ferramenta conhecida como “sparse autoencoder” em cada uma das suas camadas. Pode pensar no sparse autoencoder como um microscópio que permite ampliar e observar os detalhes dessas camadas. Por exemplo, se fizer uma pergunta sobre um chihuahua à Gemma , esta ativa a característica “cães”, que apresenta o que o modelo sabe sobre “cães”. É considerada “sparse” (que significa “esparsa” em português) por limitar o número de neurónios usados, basicamente impulsionando uma representação mais eficiente e generalizada dos dados.

O desafio dos sparse autoencoders é escolher o nível de detalhe desejado. Pense novamente no microscópio: pode ampliar algo a um nível extremo, mas isso pode tornar o que observa impossível de interpretar por um humano. No entanto, se fizer o contrário em demasia, existe a possibilidade de estar a limitar os elementos interessantes que podem ser observados e descobertos.

A solução da DeepMind foi utilizar sparse autoencoders de tamanhos diferentes, variando o número de características que querem que o autoenconder encontre. O objetivo não era os investigadores da DeepMind analisarem os resultados minuciosamente de forma independente. A Gemma e os autoencoders são de código aberto, pelo que o objetivo deste projeto era, sobretudo, incentivar os investigadores interessados a observar aquilo que os sparse autoencoders descobriram e, possivelmente, fazer novas descobertas acerca da lógica interna do modelo. Uma vez que a DeepMind utilizou autoencoders em cada camada do seu modelo, um investigador poderia mapear o progresso da introdução à saída dos dados de forma inédita.

“Isto é realmente empolgante para os investigadores da interpretabilidade”, diz Josh Batson, um investigador da Anthropic. “Tendo este modelo de código aberto para estudo, uma série de investigações acerca da interpretabilidade pode agora ser feita a partir desses sparse autoencoders, o que facilita o acesso à aprendizagem a partir destes métodos.”

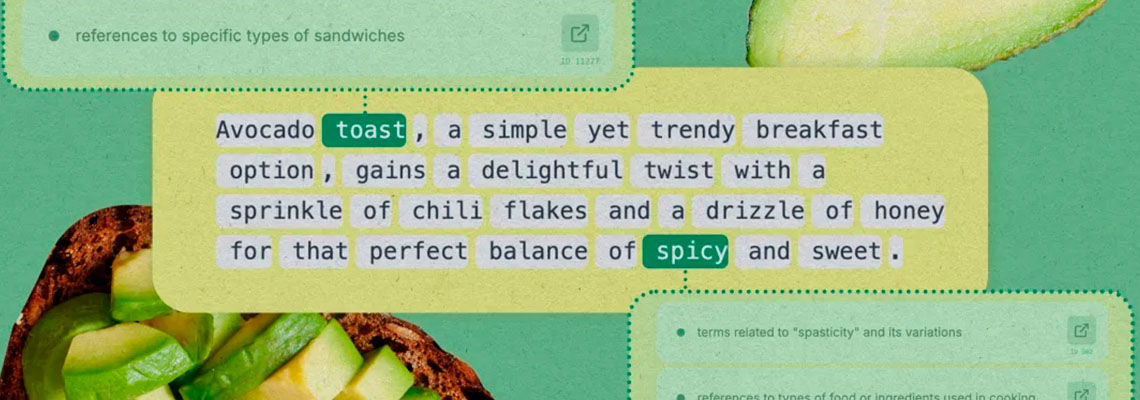

Em julho, a Neuronpedia, uma plataforma de mechanistic interpretability, colaborou com a DeepMind para criar uma demonstração da Gemma Scope que está agora acessível ao público para testes. Nela, é possível testar prompts diferentes e ver como o modelo as divide e que ativações acionam. É também possível usar o modelo para experimentações menos sérias: por exemplo, ao aumentar bastante a característica sobre cães e, em seguida, fazer uma pergunta sobre os presidentes dos Estados Unidos, a Gemma vai encontrar uma forma de incluir uma referência aleatória a cães, ou pode até mesmo começar a ladrar.

Um facto interessante dos sparse autoencoders é o facto de não serem supervisionados, ou seja, identificam características independentemente, o que leva a descobertas surpreendentes sobre a forma como os modelos repartem conceitos humanos. “A minha característica preferida é a característica cringe”, diz Joseph Bloom, líder científico da Neuronpedia. “Parece surgir em críticas negativas de textos e filmes. É um ótimo exemplo da procura de coisas que são tão humanas a um certo ponto.”

É possível pesquisar conceitos na Neuronpedia, que destaca as características ativadas em tokens específicos, ou palavras, e o nível de intensidade das suas ativações. “Se ler um texto e vir algo destacado a verde, esses são os exemplos em que o modelo acha que o conceito cringe é mais relevante. O exemplo mais ativo deste conceito é alguém a pregar a outra pessoa”, explica Bloom.

Algumas características estão a mostrar-se mais fáceis de seguir do que outras. “Uma das características mais importantes que se gostaria de encontrar num modelo é deception”, diz Johnny Lin, fundador da Neuronpedia. “Não é muito fácil encontrar uma característica que avise quando a IA está a mentir. Com base no que observei, ainda não é possível encontrar e banir o ato de enganar.”

A investigação da DeepMind é semelhante à que a Anthropic, uma outra empresa de IA, fez em maio com a demonstração do Golden Gate Claude. A empresa utilizou sparse autoencoders para identificar as partes de Claude, o seu modelo, que eram ativadas ao falar sobre a ponte Golden Gate, em São Francisco. Depois disso, amplificou as ativações até ao ponto de Claude literalmente não se identificar como Claude, um modelo de IA, mas como a própria ponte Golden Gate, respondendo às prompts como se fosse a ponte.

Embora possa parecer peculiar, a investigação sobre a mechanistic interpretability pode revelar-se incrivelmente proveitosa. “Enquanto ferramenta para entender a forma como o modelo generaliza e em que nível de abstração opera, estas características são muito úteis”, diz Batson.

Por exemplo, uma equipa liderada por Samuel Marks, agora na Anthropic, usou sparse autoencoders para encontrar características que mostravam que um modelo em particular associava determinadas profissões a um género específico. A equipa desativou então essas características para reduzir vieses no modelo. Essa experiência foi realizada num modelo bastante pequeno, pelo que não está claro se o trabalho se irá aplicar a um modelo muito maior.

A investigação da mechanistic interpretability também nos pode ajudar a entender por que razão a IA comete erros. No caso da afirmação que 9,11 é maior que 9,8, os investigadores do laboratório de investigação norte-americano Transluce descobriram que a pergunta estava a ativar as partes de um modelo associadas a versículos bíblicos e ao 11 de setembro. Eles concluíram que a IA poderia estar a interpretar os números como datas, afirmando a data 9/11 como maior que 9/8. Para além disso, em muitos livros, como textos religiosos, a secção 9.11 surge depois da 9.8, o que pode explicar por que a IA indicava que 9,11 era maior. Assim que entenderam o motivo do erro, os investigadores regularam as ativações da IA relativas a versículos bíblicos e ao 11 de setembro, o que levou o modelo a responder corretamente quando questionado se 9,11 era maior que 9,8.

Existem também outros possíveis usos. Atualmente, os grandes modelos de linguagem têm incorporada uma prompt ao nível do sistema para lidar com situações como, por exemplo, utilizadores que perguntam como construir bombas. Quando é feita uma pergunta ao ChatGPT, o modelo é primeiro secretamente instruído pela OpenAI a não fornecer instruções de como construir bombas ou fazer outras coisas moralmente erradas. No entanto, os utilizadores conseguem facilmente evadir a IA com prompts astutas, contornando quaisquer restrições.

Se os criadores dos modelos conseguirem identificar onde está a informação relativa à construção de bombas, eles podem, teoricamente, desligar esses nós permanentemente. Desta forma, nem a prompt mais astuta iria obter respostas acerca de como construir uma bomba uma vez que o modelo não teria qualquer informação sobre o tópico no seu sistema.

É fácil imaginar este tipo de detalhe e controlo preciso, mas é extremamente difícil alcançá-lo dado o estado atual da mechanistic interpretability.

“Uma limitação é o facto de o ato de influenciar um modelo através do ajuste dos seus parâmetros não estar a funcionar muito bem, pelo que quando se tenta reduzir a violência no modelo, o seu conhecimento em artes marciais acaba por ser negativamente afetado. Ainda há muito a melhorar nesse campo”, diz Lin. O conhecimento sobre a “construção de bombas”, por exemplo, não é um simples interruptor dentro de um modelo de IA; provavelmente está incorporado em várias partes, e desligá-lo poderia vir a afetar o conhecimento de química da IA. Um pequeno ajuste pode ter benefícios, mas também desvantagens significativas.

Assim sendo, se conseguirmos investigar mais a “mente” da IA, a DeepMind e outras empresas acreditam que a mechanistic interpretability pode ser um caminho viável para o alinhamento, isto é, o processo de garantir que a IA está, de facto, a fazer exatamente o que queremos que faça.