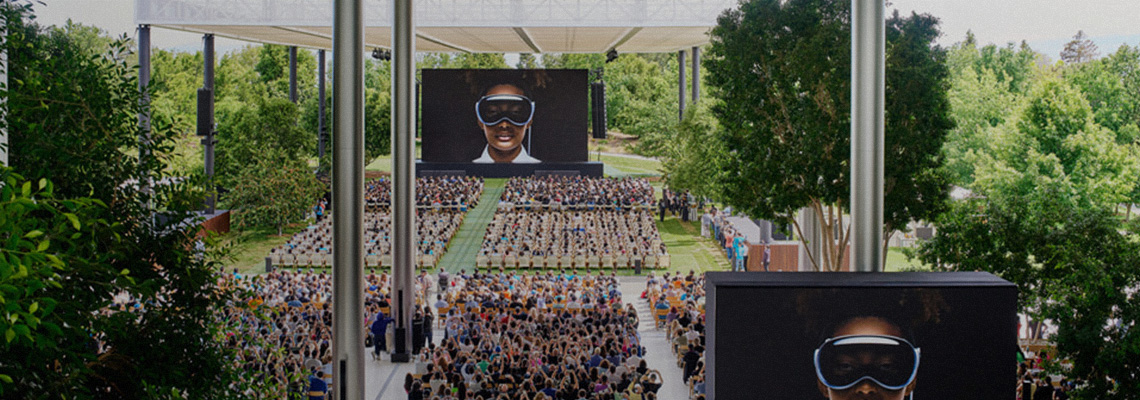

Na sua Conferência Mundial de Desenvolvedores (WWDC), a Apple revelou pela primeira vez a sua visão para integrar Inteligência Artificial em toda a sua linha de produtos. O principal recurso, que estará presente em praticamente todos os seus produtos, é o Apple Intelligence, um conjunto de funcionalidades baseadas em IA que promete oferecer serviços personalizados mantendo a segurança dos dados confidenciais.

Esta novidade representa o maior avanço da Apple no uso dos nossos dados privados para auxiliar a IA na realização de tarefas em nosso nome. Para assegurar que isso seja feito sem comprometer a privacidade, a empresa afirma ter desenvolvido uma nova abordagem para o tratamento de dados confidenciais na nuvem.

A Apple alega que o seu sistema focado na privacidade visa, primeiramente, executar as tarefas de IA localmente no próprio dispositivo. Caso haja a necessidade de interação com serviços na nuvem, os dados serão criptografados e posteriormente excluídos. Além disso, a empresa afirma que este processo, denominado Private Cloud Compute, será sujeito à verificação por parte de pesquisadores de segurança independentes.

Este argumento apresenta um contraste implícito com empresas como a Alphabet, Amazon ou Meta, que coletam e armazenam grandes volumes de dados pessoais. A Apple garante que todos os dados pessoais enviados para a nuvem serão utilizados exclusivamente para a tarefa de IA em questão, não sendo retidos ou acessíveis à empresa, nem mesmo para fins de depuração ou controlo de qualidade, após a conclusão do pedido.

Em resumo, a Apple assegura que pode analisar dados altamente confidenciais – como fotos, mensagens e e-mails contendo detalhes íntimos das nossas vidas – e oferecer serviços automatizados com base no que encontrar, sem armazenar os dados online ou torná-los vulneráveis.

A empresa apresentou alguns exemplos de como isso funcionará nas próximas versões do iOS. Por exemplo, em vez de procurar manualmente numa conversa a referência a um podcast enviado por um amigo, poderá simplesmente pedir à Siri para o encontrar e reproduzir. Craig Federighi, vice-presidente sénior de engenharia de software da Apple, apresentou outro cenário: ao receber um e-mail que adia uma reunião de trabalho, mas sabendo que a sua filha participa nessa noite numa peça de teatro, o seu telefone poderá localizar o PDF com informações sobre a peça, prever o trânsito local e informar se conseguirá chegar a tempo. Estas funcionalidades serão estendidas para além das aplicações desenvolvidas pela própria Apple, permitindo aos programadores utilizar também a IA da Apple.

Devido ao facto de a empresa obter mais receitas com hardware e serviços do que com publicidade, a Apple tem menos incentivos do que algumas outras empresas para recolher dados pessoais online, o que lhe permite posicionar o iPhone como o dispositivo mais seguro em termos de privacidade. No entanto, a Apple já foi alvo de críticas por questões de segurança, como os vazamentos de fotos explícitas do iCloud em 2014. Em 2019, foi revelado que funcionários contratados estavam a ouvir gravações íntimas da Siri para fins de controlo de qualidade. Além disso, estão em curso disputas sobre a forma como a Apple lida com pedidos de dados por parte das autoridades policiais.

Segundo a Apple, a primeira linha de defesa contra violações de privacidade é evitar o processamento em nuvem para tarefas de IA sempre que possível. “O pilar do nosso sistema de inteligência pessoal é o processamento no dispositivo”, afirma Federighi, o que implica que muitos dos modelos de IA serão executados em iPhones e Macs, e não na nuvem. “O sistema conhece os seus dados pessoais sem os recolher.”

Este cenário apresenta alguns desafios técnicos. Mesmo dois anos após o boom da IA, a execução de modelos, mesmo para tarefas simples, ainda requer enormes recursos computacionais. É difícil realizar isso com os chips usados em telefones e laptops, razão pela qual apenas os modelos menores de IA do Google podem ser executados nos telefones da empresa, enquanto os restantes são processados na nuvem. A Apple afirma que a sua capacidade de lidar com cálculos de IA no dispositivo é resultado de anos de pesquisa em design de chips, culminando nos chips M1 lançados a partir de 2020.

No entanto, mesmo com os chips mais avançados da Apple, não é possível lidar com todas as tarefas prometidas pela IA. Se pedir à Siri para executar uma tarefa complexa, poderá precisar enviar essa solicitação, juntamente com os seus dados, para modelos disponíveis apenas nos servidores da Apple. Especialistas em segurança apontam que esta etapa introduz várias vulnerabilidades que podem expor as suas informações a agentes mal-intencionados externos ou, pelo menos, à própria Apple.

“Sempre alerto as pessoas de que, assim que os dados saem do dispositivo, tornam-se muito mais vulneráveis”, diz Albert Fox Cahn, diretor executivo do Surveillance Technology Oversight Project e profissional residente no Information Law Institute da NYU Law School.

A Apple alega ter mitigado este risco com o seu novo sistema de Computação em Nuvem Privada. “Pela primeira vez, a Private Cloud Compute estende a segurança e a privacidade líderes do setor dos dispositivos Apple para a nuvem”, afirmaram os especialistas em segurança da Apple no seu anúncio, garantindo que os dados pessoais “não são acessíveis a ninguém, exceto ao utilizador – nem mesmo à Apple”. Como funciona isto?

Historicamente, a Apple tem incentivado os utilizadores a optarem pela criptografia ponta a ponta (semelhante à tecnologia usada em aplicações de mensagens como o Signal) para proteger os dados confidenciais no iCloud. No entanto, isto não se aplica à IA. Ao contrário das aplicações de mensagens, onde uma empresa como o WhatsApp não precisa ver o conteúdo das suas mensagens para entregá-las aos seus amigos, os modelos de IA da Apple requerem acesso não criptografado aos dados subjacentes para gerar respostas. É aqui que entra o processo de privacidade da Apple. Primeiramente, os dados são usados apenas para a tarefa em questão. Em segundo lugar, este processo é verificado por pesquisadores independentes.

A arquitetura deste sistema é complexa, podendo ser comparada a um protocolo de criptografia. Se o seu telefone determinar que necessita da ajuda de um modelo de IA mais robusto, enviará uma solicitação contendo o pedido utilizado e o modelo específico, e colocará um bloqueio nessa solicitação. Apenas o modelo de IA específico terá a chave adequada para acessá-la.

Questionada pela MIT Technology Review se os utilizadores serão notificados quando uma determinada solicitação for enviada para modelos de IA baseados em nuvem, em vez de ser processada no dispositivo, a Apple afirmou que haverá transparência para os utilizadores, mas que mais detalhes não estão disponíveis no momento.

Dawn Song, co-diretora do UC Berkeley Center on Responsible Decentralized Intelligence e especialista em computação privada, considera os novos desenvolvimentos da Apple encorajadores. “A lista de objetivos que eles anunciaram é bem pensada”, diz ela. “Claro que haverá desafios para alcançar esses objetivos.”

Cahn, por outro lado, afirma que, com base no que a Apple divulgou até agora, o sistema parece ser muito mais protetor da privacidade do que outros produtos de IA atualmente disponíveis. No entanto, o mantra comum neste espaço é “Confie, mas verifique”. Em outras palavras, só saberemos até que ponto esses sistemas mantêm nossos dados seguros quando pesquisadores independentes verificarem as alegações da Apple e a empresa responder às suas descobertas.

“A abertura à análise independente por parte de pesquisadores é um grande passo”, diz ele. “Mas isso não determina como a empresa responderá quando os pesquisadores trouxerem informações indesejadas.” A Apple não respondeu às perguntas da MIT Technology Review sobre como avaliará o feedback dos pesquisadores.

A barganha entre privacidade e IA

A Apple não é a única empresa que aposta que muitos de nós concederão acesso quase irrestrito aos nossos dados privados aos modelos de IA se isso significar a automação de tarefas tedios

É uma barganha que forçará muitos de nós a considerar, pela primeira vez, qual papel queremos que os modelos de IA desempenhem na forma como interagimos com os nossos dados e dispositivos. Quando o ChatGPT entrou em cena pela primeira vez, essa não era uma questão que precisávamos fazer. Era simplesmente um gerador de texto que podia escrever-nos um cartão de aniversário ou um poema, e as questões que levantava – como a origem dos dados de treino ou os preconceitos que perpetuava – não pareciam tão pessoais.

Agora, menos de dois anos depois, a Big Tech está a fazer apostas de bilhões de dólares para que confiemos na segurança desses sistemas o suficiente para entregarmos as nossas informações privadas. Ainda não está claro se sabemos o suficiente para tomar essa decisão, ou se somos capazes de optar por não participar, mesmo que queiramos. “Preocupa-me que esta corrida armamentista de IA esteja a empurrar cada vez mais os nossos dados para as mãos de outras pessoas”, diz Cahn.

Em breve, a Apple lançará versões beta dos seus recursos de Apple Intelligence, começando neste outono com o iPhone 15 e o novo macOS Sequoia, que pode ser executado em Macs e iPads com chips M1 ou mais recentes. Tim Cook, CEO da Apple, afirma: “Acreditamos que a inteligência da Apple será indispensável”.