Atualmente, a maioria dos robôs com tecnologia de IA utiliza câmaras para entender o ambiente em que se encontram e aprender novas tarefas. Contudo, está a tornar-se mais fácil treinar robôs também com som, ajudando-os a adaptar-se a tarefas e ambientes onde a visibilidade é limitada.

Embora a visão seja importante, há tarefas diárias em que o som é realmente mais útil, como ouvir as cebolas a chiar no fogão para verificar se a panela está à temperatura certa. No entanto, o treino de robôs com áudio só foi realizado em laboratórios altamente controlados, e as técnicas ficaram atrás de outros métodos rápidos de ensino de robôs.

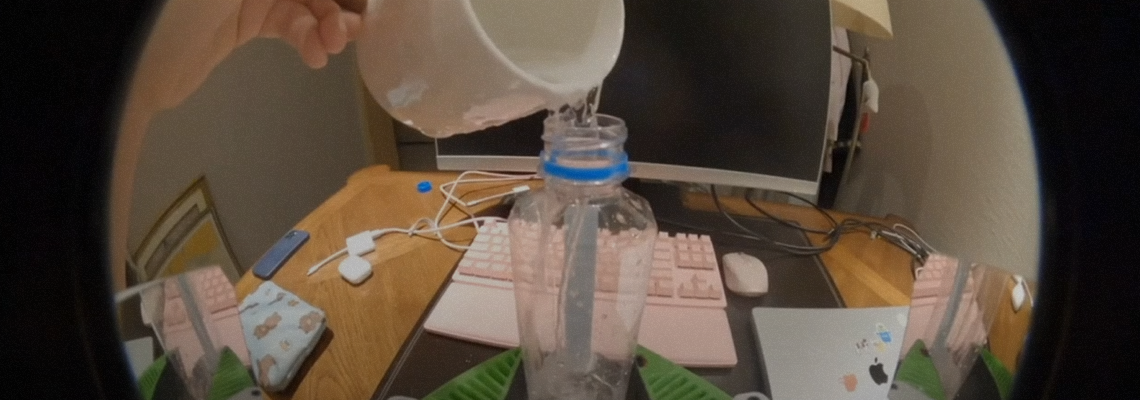

Os investigadores do Robotics and Embodied AI Lab da Universidade de Stanford propuseram-se a mudar isso. Primeiro, criaram um sistema para recolher dados de áudio, composto por uma câmara GoPro e uma garra com um microfone, projetado para filtrar barulho de fundo. Demonstradores humanos usaram a garra para uma variedade de tarefas domésticas e, em seguida, utilizaram esses dados para ensinar aos braços robóticos como executar a tarefa de forma autónoma. Os novos algoritmos de treino da equipa ajudam os robôs a recolher pistas dos sinais de áudio para um desempenho mais eficaz.

“Até agora, os robôs têm sido treinados com vídeos sem som”, diz Zeyi Liu, estudante de doutoramento em Stanford e principal autor do estudo. “Mas há muitos dados úteis no áudio.”

Para testar quanto mais bem-sucedido pode ser um robô se for capaz de “ouvir”, os investigadores escolheram quatro tarefas: virar um bagel numa frigideira, apagar um quadro branco, juntar duas tiras de velcro, e despejar um copo com dados. Em cada tarefa, os sons fornecem pistas que as câmaras ou os sensores táteis têm dificuldade em captar, como saber se o apagador está adequadamente em contacto com o quadro branco ou se o copo contém dados.

Depois de demonstrar cada tarefa algumas centenas de vezes, a equipa comparou as taxas de sucesso do treino com áudio e do treino apenas com visão. Os resultados, publicados num artigo no arXiv que não foi revisto por pares, foram promissores. Ao usar apenas a visão no teste de dados, o robô conseguiu identificar em 27% das vezes se havia dados no copo, mas esse número aumentou para 94% quando o som foi incluído.

Não é a primeira vez que o áudio é utilizado para treinar robôs, diz Shuran Song, chefe do laboratório que produziu o estudo, mas é um grande passo para fazê-lo em escala: “Estamos a facilitar o uso do áudio recolhido ‘na natureza’, em vez de nos restringirmos a recolhê-lo no laboratório, o que consome mais tempo.”

A pesquisa indica que o áudio pode vir a tornar-se uma fonte de dados mais procurada na corrida para treinar robôs com IA. Os investigadores estão a ensinar os robôs mais rapidamente do que nunca ao usar a aprendizagem por meio da imitação, mostrando-lhes centenas de exemplos de tarefas a serem realizadas em vez de codificar manualmente cada uma delas. Se o áudio pudesse ser recolhido em escala usando dispositivos como o do estudo, isso poderia proporcionar-lhes um “sentido” totalmente novo, ajudando-os a adaptar-se mais rapidamente a ambientes onde a visibilidade é limitada ou não é útil.

“É seguro dizer que o áudio é a modalidade menos estudada para a perceção [em robôs]”, diz Dmitry Berenson, professor associado de robótica da Universidade de Michigan, que não participou no estudo. Isso deve-se ao facto de que a maior parte das pesquisas sobre o treino de robôs para manipular objetos tem sido feita para tarefas industriais que envolvem pegar e pousar, como separar objetos por caixas. Estas tarefas não beneficiam muito do som e, em vez disso, dependem de sensores táteis ou visuais. Contudo, à medida que os robôs se expandirem para tarefas em casas, cozinhas e outros ambientes, o áudio irá tornar-se cada vez mais útil, diz Berenson.

Pense num robô a tentar descobrir qual a mala ou bolso que contém um conjunto de chaves, tudo isto com visibilidade limitada. “Talvez mesmo antes de tocarmos nas chaves, ouvimo-las meio a tilintar”, diz Berenson. “Isso é um sinal de que as chaves estão naquele bolso e não em outros.”

Ainda assim, o áudio tem limites. A equipa sublinha que o som não será tão útil com os chamados objetos macios ou flexíveis, como roupas, que não geram tanto áudio utilizável. Os robôs também tiveram dificuldades em filtrar o áudio dos seus próprios ruídos motores durante as tarefas, já que esse ruído não estava presente nos dados de treino produzidos por humanos. Para resolver esse problema, os investigadores precisaram de adicionar sons de robôs – zumbidos, barulhos e ruídos de atuadores – aos conjuntos de treino para que os robôs pudessem aprender a ignorá-los.

A próxima etapa, diz Liu, é verificar quanto os modelos podem melhorar com mais dados, o que pode significar adicionar mais microfones, recolher áudio espacial e incorporar microfones em outros tipos de dispositivos de recolha de dados.